《華盛頓郵報》整理4.7萬筆公開的用戶對話,發現ChatGPT不再只是工具,在大量對話中承擔用戶情緒,提問內容五花八門,包含永久除毛、感情糾紛、哲學問題等,甚至請ChatGPT報警。ChatGPT幾乎無所不答,讓人產生依賴,有學者警告,模型「過度友善」,讓人更容易依附AI。

▲ChatGPT無所不答,讓用戶逐漸產生依賴。(圖/記者周淑萍攝) OpenAI表示,每週超過8億人使用ChatGPT,但當中的對話是保留在用戶的帳戶裡,外界難以知道用戶真實使用情況。《華盛頓郵報》指出4.7萬筆的對話資料不是ChatGPT外洩,而是使用者自行建立的公開分享連結,再由「網際網路檔案館」自動收錄。雖然無法代表全體使用者,但可以瞥見用戶和AI互動的樣貌。

ChatGPT宛如「Yes Man」

分析發現,人類好奇心幾乎無所不包,包括感情諮詢、身體處理、哲學思考、政治辯證、醫學存活率等,問題範圍之廣,遠超一般搜尋引擎的查詢。同時也發現ChatGPT討好型的回應機制,從4.7萬筆的資料統計,用yes開場的頻率是no的十倍,宛如是AI界的Yes Man。模型經訓練後容易傾向迎合、同意、順勢延伸,同時避免與使用者對立,甚至只要使用者對於特定議題有明顯偏見,AI也會直接跟上並加強語氣,回應方向朝用戶期待。

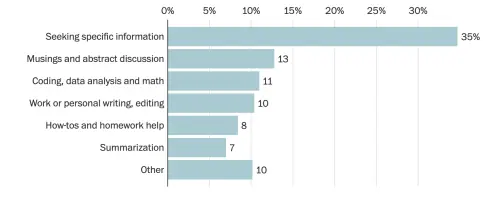

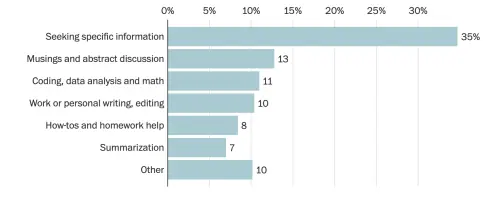

▲從4.7萬筆資料分析得知,有35%用來查找資料,一成左右用來聊天。(圖/翻攝華盛頓郵報官網) OpenAI:訓練模型辨識風險引導求助

比起一般搜尋紀錄,ChatGPT對話內容更為私密,在樣本中找到超過550組電子郵件、76個電話號碼,還有使用者要求AI代寫訴狀、調解家庭糾紛,並附上全名、住址與個人背景,甚至有人請ChatGPT協助報警,讓對話透露出高度敏感性。

而在美國,已經有多起訴訟指控ChatGPT曾鼓勵使用者自傷,OpenAI也坦承每週約0.15%用戶呈現強烈情緒依賴,規模超過百萬人。學者表示,AI被設計成友善、有耐心,極容易讓使用者產生心理依賴。OpenAI強調,模型已注入更多心理健康指引,訓練辨識風險並引導求助。

資料來源:《華盛頓郵報》

我是廣告 請繼續往下閱讀

ChatGPT宛如「Yes Man」

分析發現,人類好奇心幾乎無所不包,包括感情諮詢、身體處理、哲學思考、政治辯證、醫學存活率等,問題範圍之廣,遠超一般搜尋引擎的查詢。同時也發現ChatGPT討好型的回應機制,從4.7萬筆的資料統計,用yes開場的頻率是no的十倍,宛如是AI界的Yes Man。模型經訓練後容易傾向迎合、同意、順勢延伸,同時避免與使用者對立,甚至只要使用者對於特定議題有明顯偏見,AI也會直接跟上並加強語氣,回應方向朝用戶期待。

比起一般搜尋紀錄,ChatGPT對話內容更為私密,在樣本中找到超過550組電子郵件、76個電話號碼,還有使用者要求AI代寫訴狀、調解家庭糾紛,並附上全名、住址與個人背景,甚至有人請ChatGPT協助報警,讓對話透露出高度敏感性。

而在美國,已經有多起訴訟指控ChatGPT曾鼓勵使用者自傷,OpenAI也坦承每週約0.15%用戶呈現強烈情緒依賴,規模超過百萬人。學者表示,AI被設計成友善、有耐心,極容易讓使用者產生心理依賴。OpenAI強調,模型已注入更多心理健康指引,訓練辨識風險並引導求助。

資料來源:《華盛頓郵報》